【来源:虎嗅网】

2023 年底,新闻可信度评级机构 NewsGuard 发布了一项数据,显示在 2023 年 5 月到 12 月这个时间段,由人工智能驱动的假新闻网站增长了 1000%,数量从 49 个激增到 600 多个。

而到 2024 年 6 月,这个数字已经变成 1265 个。NewsGuard 将其称为“一个可悲的里程碑”。因为根据测算,人工智能驱动的假新闻网站,数量正式超过了美国本土的报纸网站数量(1213 家)。

这确实是新闻业的可悲现状。传统的、值得信赖的、机构化的本地新闻来源正在大批次地湮灭,2005 年到 2022 年期间,美国约有 2500 家当地报纸倒闭,取而代之的却是大量的 AI 假新闻网站。这些网站正成为许多不明真相者的信息来源,并进一步流传到社交网络中,变成流行甚广的虚假社交货币。

AI 假新闻正在泛滥,这样的趋势同样在国内发生。今年年初,西藏日喀则定日县发生 6.8 级地震,多张“小男孩被埋图”在网络疯传,引发广泛关注。后经公安机关核查,这些图片均由一位青海网友使用 AI 工具生成,并上传网络,引发谣言扩散。

新闻截图

不久前“顶流男星豪赌 10 亿”也是相当典型的案例。根据公安部的通告,这是某网民使用 AI 生成功能,输入社会热点词制作的假新闻。

AI 生成的假新闻似乎日益常见,对普通冲浪用户来说,已经越来越难辨真假。因此其影响范围也越来越大,后果愈发恶劣。

这显然与生成式 AI 飞速的技术进展无法分开。从 2022 年底 ChatGPT 发布,到今天已经两年多的时间。在这期间,AI 在文字层面的生成能力日益成熟,人工与智能的界限越发模糊。在多模态生成领域,短短一两年间,生成式 AI 从生成质量很差、细节粗糙的图片,到几乎无法辨认真假的图像甚至视频,实现了逼真的转变。

在我们已经习惯生成式 AI 进展飞速的同时,它的可供性和可及性,也正在降低假新闻生成、制作乃至传播的门槛。

自人类诞生以来,谣言就一直存在,假新闻几乎也与新闻同时诞生。但虚假信息和错误信息,之所以在这个时代成为我们必须关注甚至警惕的问题,是因为借助工具,任何人都能轻松创建假新闻和假图像,而这些虚假内容正在随着技术进步,而变得与真实信息无疑。

一个大假新闻时代正在到来。每个人都可能成为假新闻的制造者和传播者,另一部分人则成为假新闻的受害者。

在过去,制作假新闻的成本虽然不高,但也有门槛。造假者需要搜索资料进行整合、编造,要编造虚假的作者署名、背景,要在平台上传,可能还需要制作一个假新闻网站,并进行基本的视觉设计,使其看起来像一家正规新闻网站。

而现在,AI 在几分钟内就能完成大部分工作。AI 能够创造假作者,以及这位假作者的经历、署名、照片,还能生成网站的代码框架,迅速建成一个像模像样的网站。至于假新闻本身,那更是 AI 所擅长的,一篇图文并茂甚至包含当事人采访的视频在极短的时间就能生成好。

过往“制造”一篇假新闻所需要的时间窗口,现在经过AI的助力,已经可以生成上百篇。

对于普通读者来说,这些假新闻已经足够“真实”。与传统的假新闻相比,AI 生成的假新闻文字报道风格很接近真人,有图有真相,甚至有视频有真相。造假者可以通过提示词的调配,使生成的内容最大限度地应和受众或恐慌或猎奇的心理,以形成最大的舆论爆点。同时,由于生成式AI的使用门槛低,假新闻的制造主体泛化,信源难以查明,所以从假新闻中分辨事实,已经比以往各种时候都要困难。

造假者驱动的工具可以轰隆隆昼夜不停地运行,成为7*24小时扭曲现实的谎言制造机。如 NewsGuard 的研究员 Jack Brewster 说:“其中一些网站每天产生数百篇文章,这就是为什么我们称它为‘下一个巨大的错误信息超级传播者’。”

2025 年 6 月中旬,国内一家 MCN 机构的实际控制人王某某被警方予以行政处罚。原因是王某某利用 AI 生成虚假新闻并大肆传播,扰乱公共秩序。根据警方通报,王某某共经营 5 家 MCN 机构,运营账号 842 个。自 2025 年 1 月以来,王某某通过 AI 生成虚假新闻,最高峰一天能生成 4000 到 7000 篇。很难想象这么大规模的假新闻流入信息市场后,会对信息生态造成怎样的影响。

问题是,AI 只是工具,驱动它们来制造假新闻的人为什么愿意铤而走险?

首先,当然是为了获取利益。逻辑很简单,假新闻的生产成本极低,但是却更容易比真新闻传播,因此容易带来更大的关注度和点击量,点击量则直接与收益挂钩。

根据 NewsGuard 对假新闻网站的研究发现,在前 100 名的数字广告商中,有 55% 将广告投放在虚假信息网站上,在所有的行业和品牌中,67% 的数字广告最终出现在虚假信息网站。前文中提到的王某某,他编造的虚假新闻中最高一条收入可达到 700 元,根据警方估算,王某某每天的收入能够达到 1 万元以上。

其次,是猎奇心理驱使。这一点主要是许多普通用户的动机。因为 AI 的使用太便利了,出于猎奇心理,很多普通用户会通过蹭热点事件,利用 AI 做一些图片或假新闻。对他们来说,这种行为带不来实际的商业利益,但是其他用户的点赞、互动或是反馈都给他们带来了巨大的满足感。

比如前段时间中美谈判,有些人为了“玩梗”,利用 AI 生成的谈判代表酒桌敬酒图,就属于这种心理动机的产物。还有一些人,生成假新闻之后只是在私域小圈子内发一发,博朋友一笑,但是说不定这条信息会被谁转发到公域,脱离语境后很容易“破圈”,造成恶劣影响,这是当事人难以预料的。

另外,由于生成式 AI 自身也仍然存在幻觉问题。当这些幻觉问题被以不负责任的方式引用、传播之后,假新闻就开始泛滥了。

更值得关注的是,由于生成式 AI 的训练原理,AI 生成的假新闻正在成为内容循环的源头。当用户将 AI 生成的内容进行发布、传播,这些内容存在于网络公域中,很可能会被 AI 再次抓取,构成 AI 训练数据集的一部分,由此构成假新闻的生成循环。

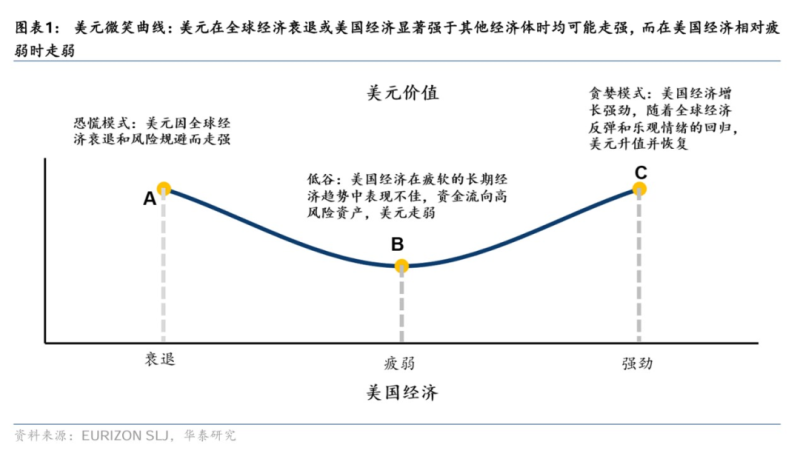

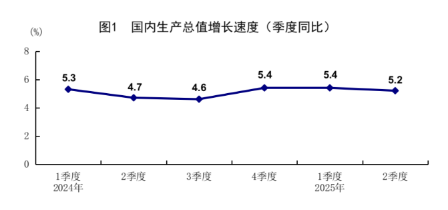

假新闻的影响力越来越大,并且开始在各个领域蔓延。世界经济论坛的《2024 年全球风险报告》已经将错误信息和虚假信息确定为未来几年的严重威胁。

全球风险严重程度排序,错误信息和虚假信息排在短期(2年)第1位,长期(10年)第5位

假新闻使用户的知情权被严重侵害,同时会强化个人偏见,引发情绪化的对立,形成群体之间的“网络巴尔干效应”。在危机事件发生期间,假新闻往往最先传播并获得关注,这会阻碍真相的传递,引发不必要的群众恐慌。

而当 AI 假新闻泛滥,更长远的影响是真相与虚假的边界将进一步趋于模糊,带来公众信任的永久缺失。真实的图片和文字会被质疑是虚假的,一切事实细节的真实性都将被严厉拷问,但另一方面,许多编造的事实又将被轻信。人们区分事实与虚构的能力将被逐渐弱化。伴随 AI 生成能力的提升,无论是用肉眼、经验还是借助工具的区分都将变得困难。

因此,大假新闻时代同时也会是一个信任严重缺失的时代。毕竟,如果分不清真假,人们的第一反应就是会对一切保持怀疑。

机构媒体在这波不信任的浪潮里首当其冲。很多媒体已经被 AI 坑过了。比如 ChatGPT 刚火起来的那段时间,美国著名科技新闻网站 CNET.com,一口气上线了几十篇 AI 生成的文章,但是很快就被读者发现,这些文章里有大量的基础性事实错误。此后,CNET 对其中 41 篇使用人工智能撰写的报道进行了更正,并宣布将暂停所有网站上的人工智能生成内容。但机构的信誉已经不可避免地受到损害了。

对于 AI 假新闻问题,人工智能平台已经设置了一些参数来进行限制。比如,DALL-E 不允许用户创建真人图像,微软的选项禁止“欺骗性冒充”。Midjouney 将“名人或公众人物的冒犯性或煽动性图像”作为违反其社区准则的内容案例。暴力和色情图像也被一些平台所禁止生成。

但平台的防范永远无法抵御别有用心者的主观恶意。他们总会寻找各种方法和漏洞,来利用 AI 作恶。比如通过更换提示词的方式绕过平台的限制性手段。而类似于 Stable Diffusion 这样的开源技术,也同样为防治带来了难度。因为开源就意味着模型可以被下载和被修改,允许用户在描述和生成方面有更多的自由。

技术可能无法担任信息真实的重任,这一点 AI 也承认。2023 年底,刚满一周岁的 ChatGPT 在接受《时代》“采访”时,承认自身在信息质量上的不足:“我尽我所能提供准确和有用的信息,但我不是一个完美的知识来源,我并不能总是提供完整或正确的答案。”

AI 从人类的指令中生成文字、图像,其生成的结果基于使用者的要求,也基于模型已经通过训练获得的知识。而这些知识,是由人类在三十多年的互联网使用史中集体缔造的。生成式 AI 所生成的内容,再现了人类的想法与价值观,其中的偏见和错误,反映了人类社会本就存在的问题。此前,我曾关注过一段时间的算法歧视问题,到最后得出来一个比较悲观的结论,算法歧视只是人类社会歧视问题的结构性延伸。某种程度上,假新闻也是一样。

所以,面对这个大假新闻时代,要在一定程度上缓解假新闻的问题,除了从各种技术手段上进行防治,可能从“人”的角度入手才是最根本也最有效的。相比关注技术,更重要的是关注技术的使用以及使用它的意图。

而对个人来说,需要掌握一些技巧来应对 AI 假新闻。比如,遇到一个可疑的新闻时,最有效的方式是查看它的信息来源:是来自专业新闻机构?还是来自可疑的网站,又或者干脆是自媒体、营销号?学会到值得信赖的新闻来源去核查,他们是否有报道这条新闻。这个过程被称为“横向阅读”,即超越内容本身进行检索,以了解超越内容本身的信息。

主动寻找真相,不沉溺于情绪和固有的认知,这是在大假新闻时代相当实用的一条生存法则。

本文来自微信公众号:正经研究,作者:苏伦salen