【来源:虎嗅网】

谁先训练出AGI,谁先合围起AI生态,足以决定大模型的未来。前者往往占据头条,但后者正在成为整个行业更紧迫的挑战。这一战已经从OpenAI宣布重新开源后正式打响,但谷歌凭借着完整的技术栈与生态,正在恢复王者气象。

今天,在谷歌云Next’25峰会上,这家科技巨头发布了搭建下一代高能效算力基础设施的Ironwood,提供高性价比推理的新一代主力模型Gemini 2.5 Flash,以及实现爆发中的智能体互操作的新标准Agent2Agent。

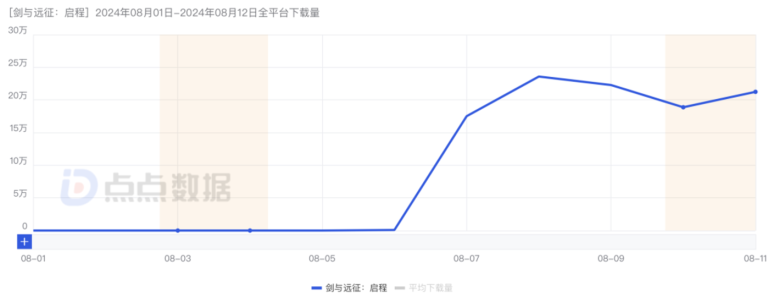

尽管微软搞出一些退租数据中心的小插曲,但爆款应用不时提醒着,现在仍处于算力紧缺状态。DeepSeek凭借开源的高性价比的模型,成为推动应用规模落地的重要功臣,但自身官方应用的用户体验,却又受制于算力供给规模;中国市场到处抢购一体机。在GPT-4o图片生成开放后,OpenAI的GPU都被暴涨的需求“融化了”,前两周,奥特曼还在急求,谁能邮他十万个GPU。

谷歌同样面临这样的局面。研究公司Omdia的估计,谷歌去年在TPU上的支出,在60亿至90亿美元之间。但它同时还下单了超过100亿美元的Blackwell芯片。最近,它还在寻求从CoreWeave那里租赁更多的英伟达GPU。它需要更为推理友好的AI芯片。

于是,谷歌第七代TPU(张量处理单元)Ironwood诞生了,它被称为谷歌首款专门为推理而设计(designed specifically)的AI芯片,全方位超越了不到一年前发布的Trillium。看来,谷歌的芯片团队顶住了这一年来被OpenAI挖人的压力。

推理正在朝着统一多模态与思维链的方向发展,需要完成越来越多能源与数据密集任务。除了单卡性能要足够强大外,芯片能效与内存也是升级的重要方向。Ironwood足以与去年发布的B200相媲美。单看FP8精度下的峰值算力,单个Ironwood芯片达到4,614万亿次浮点运算(TFLOPs),与B200相当(约5 PFLOPs),称得上当前最强水平。它的单芯片的HBM内存容量达到了192GB,是Trillium的6倍;HBM带宽达到7.2Tbps,是Trillium的4.5倍,也与B200旗鼓相当。不过,Ironwood要等今年晚间出货,届时,英伟达下一代Rubin架构芯片最快也会量产。

为了避免被美国电力瓶颈“卡了脖子”,Ironwood的能效(峰值算力FTlops/热设计功率TDP)继续大幅提升,是TPU v6的2倍,比2018年的TPU v2高了近30倍。

它可纵向扩展(scale up)至9,216个芯片,通过低延迟、高带宽的芯片间互连(ICI)网络连接,总算力达到42.5 Exaflops,总功率接近10兆瓦。它能通过Pathways技术,横向(scale out)将数十万个Ironwood芯片组合在一起,实现高效分布式计算。

每一个竞争对手都在推进自研芯片。OpenAI与博通合作的3nm芯片,会在谷歌TPU前工程高级总监Richard Ho的领导下,在几个月内完成设计,交给台积电流片,如果一切顺利,规模量产有望在2026年启动;但别指望它能马上规模部署,用于前沿模型的训练。即使微软、亚马逊与Meta的自研芯片也加速迭代,但总拥有成本仍然无法企及已经迭代到第七代的谷歌TPU。

算法提效同步推进。谷歌的主力推理模型,也在向成本敏感的方向迭代。在两周前,谷歌发布了仍处于实验版阶段Gemini-2.5-Pro,在官方公布的基准测试成绩中,它在常见的编程、数学和科学基准测试中均处于领先地位;除了编程,其他所有项目都强于o3-mini。在不到两年的时间里,GPT-4级别的模型的成本,下降了99.7%,即使是世界上最先进的模型,也便宜了82%。

这次,谷歌公开了Gemini-2.5-Flash的存在。谷歌CEO皮查伊亲自上台,介绍了这款“提供强大性能的同时注重效率”的推理模型。它最大的亮点是“动态且可控的”计算能力。这就避免了Gemini-2.5-Pro这样花大量算力去过度思考一些简单问题的状况。不过,它还没有正式发布,也没有技术报告。它面临DeepSeek即将发布的R2的挑战。

谷歌还发布了文本到音乐模型Lyria,迭代了视频生成模型Veo 2、语音生成模型Chirp 3、图像生成模型Imagen 3,成为了当前多模态最齐备的单一平台。此外,谷歌还透露,目前有超过400万开发人员,在Gemini之上构建应用。

坐拥如此生态,谷歌当然希望,智能体安卓系统的机会可以留在自己这边。于是,这次在会上,该公司发布了Agent2Agent(A2A)的新开放协议,允许不同开发者的智能体之间相互通信。这个互操作协议存在三方参与者,包括用户(User)、客户端(Client)与服务器(Server,即远程智能体)。

客户端可以是智能体或应用程序,它代表用户创建任务(task),识别并向适合完成这项任务的远程智能体,以消息(message,包含用户上下文、指令、错误、状态或元数据等内容)的形式发起请求,后者可以立即完成任务,输出工件(artifact,任务的结果,单个任务可以拆分为多个工件来实现),也可以长时间运行,期间与客户端保持状态沟通(以消息的形式),还可以向客户端询问更多信息(以消息的形式),甚至将任务委托给其他智能体。远程智能体不直接与客户端共享其工具与资源,确保安全与隐私。

谷歌不认为A2A就是谷歌版的MCP。就在两周前,OpenAI刚决定拥抱竞争对手Anthropic推出的这款AI互操作性工具。近日,阿里、腾讯开始全面支持MCP。今天,谷歌DeepMind创始人哈萨比斯也宣布,自家Gemini与SDK都支持MCP协议。

在谷歌的表述中,MCP更侧重为大模型链接那些实用的数据、资源和工具,而A2A解决的是大规模的多智能体系统的协同问题,两者是互补的。它还在官方说明文档里正大光明地推荐,调用工具(结构化的输入与输出)就用MCP吧,但是智能体(自主的应用程序,可以使用工具、推理,与用户交互)间相互调用,还是得用A2A。

谷歌还举了个例子。在汽车维修厂,维修工人是为车主服务的智能体,他可以调用千斤顶、万用表和套扳手等结构化的工具,也需要与其他维修工人沟通,如果其他维修工注意到漏液问题,他还要向车主询问这种状况持续多久了;还需要与零部件供应商这样的远程智能体沟通,从后者那里间接获取可以使用的配件。MCP就是让维修工用好工具,A2A就是让维修工用好伙伴。

2025年是智能体的一年。从Manus到AutoGLM沉思,中国团队在海外和国内开始全面卷入AI智能体的竞争。智能体解决复杂任务的能力在进步,平均每7个月翻一番。推理时代的未来,也将是多智能体自主推理的时代,意味着既需要用好工具,也需要用好伙伴。谷歌更相信后者的商业想象空间。