【来源:虎嗅网】

3月19日,OpenAI在其开发人员API上推出了o1-pro——o1推理AI模型更强大的版本。

所向披靡的Open AI,正在“创飞”一部分创业公司,只要Open AI想做某个业务,就会有一批初创公司宣告倒闭。不过,也有另一批小公司,正在OpenAI的生态之下生长。

Turing原本专注于远程的开发人才招聘,现在成为AI代码服务商——即组织工程师团队为OpenAI等公司提供代码支持。今年3月,Turing完成1.11亿美元的E轮融资,公司估值翻倍达到22亿美元,在数据标注领域仅次于Scale AI。

业绩方面,Turing创始人兼CEO Jonathan Siddharth 在社交平台高调宣布:公司2024年收入增长3倍,ARR(年度经常性收入)突破3亿美元,并成为“全球增长最快且盈利的AGI基础设施公司”。

我们试图从Turing的成长故事,挖掘大模型时代下,小企业的生存指南——在做原来业务的过程中,发现了新的机会,迅速切入AI,瞄准垂直而细分的市场。

一、Turing:从人才中介到AI“数据矿场”

Siddharth的创业故事,充满硅谷式传奇色彩。

2017年,Siddharth与斯坦福校友Vijay Krishnan创立的机器学习公司Rover被收购,这是一家利用机器学习进行深度个性化兴趣分析的公司。第二年,Siddharth就创立了Turing,利用AI技术为其客户优化人才匹配。

2020年的疫情期间,Turing获得迅速发展。因为疫情让许多公司不得不居家办公,同时也需要在线上招聘人才和管理团队,由此对Turing产生旺盛的需求。当时,Turing平台上有上百万的工程师和开发人员。对于雇主而言,使用Turing招聘可以节省50多个小时的面试时间,匹配成功率高达97%。

转折点发生在2022年。

当时Siddharth被邀请到OpenAI开会,他本来以为是去讨论招募工程师,去了之后才发现是要谈合作。OpenAI的研究人员发现,将代码添加到训练数据集中有助于提高模型的推理能力。比如,用Python代码解释“如何设计桥梁”,模型更易抽象出工程学原理。

为什么添加代码这么有用?因为代码有着严密的语法和逻辑结构,同时包含了大量的算法、数据结构等知识,有助于AI大模型学习到更抽象的语言规律。

在OpenAI眼中,Turing凭借庞大的工程师资源成为理想的“代码矿场”。OpenAI方面询问Siddharth是否可以组建一支程序员队伍完成特定的软件工程任务,以便推动OpenAI的下一个项目:GPT-4。

“我清楚地记得,他们当时的雄心壮志有多大,”Siddharth在接受 Semafor采访时说道。“他们对我们的要求非常高,想在短时间内获得大量数据。”

后来Siddharth接受了OpenAI提出的合作,一位知情的OpenAI前员工透露,Turing在帮助OpenAI提升性能方面发挥了重要作用。

当然,这场合作也为Turing开启了全新的业务方向。与OpenAI合作以来的近三年里,许多基础模型提供商以及AI模型公司都成为了Turing的客户,而且其数据标注的能力范围已超越了编程代码领域,逐渐涉及各行业的专业数据。

比如,谷歌就从2023年下半年开始跟Turing合作。从编程代码任务开始,二者达成了价值数百万美元的合作。

目前,Turing大约60%的收入来自希望训练及提升AI模型能力的客户,40%的收入来自为利用AI升级业务的客户提供咨询服务。

二、“资源-效率-社区”三板斧,筑牢护城河

随着Turing跟AI公司的合作逐渐深入,资本也对其产生了兴趣。

Turing的E轮融资,由马来西亚主权财富基金 Khazanah Nasional Berhad领投,其他参投方包括 WestBridge Capital、Sozo Ventures、UpHonest Capital威诚资本、AltaIR Capital、Amino Capital丰元创投、Plug and Play、MVP Ventures、Fortius Ventures、Gaingels 和 Mastodon Capital Management。

这些投资机构之所以押注Turing,在于它的几大优势。

首先,AI大模型的整个训练和运行,其实都非常依赖数据标记和数据投喂。

数据标记,其实就是对图像、文本、语音等数据进行标注,以便机器学习模型能够识别和分类这些数据。尽管自动化工具涌现,但数据标注仍高度依赖人类。目前,Scale AI已经成为头部的数据标注服务商。其拥有庞大的数据标记师团队,大多是来自非洲、印度和菲律宾的廉价劳动力。根据The information报道,Scale AI的年化收入至2024年5月已经突破10亿美元,估值突破138亿美元。

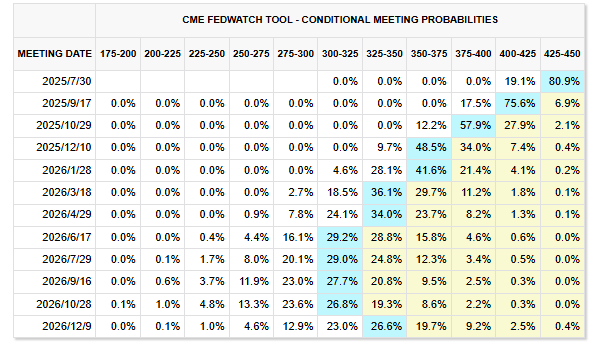

不过,人类对大模型推理能力要求在不断提高。大模型除了需要传统的数据标注,还需要代码输入,说白了就是从“体力劳动”转向“脑力协作”。Bloomberg Research指出预计到2032年模型训练市场价值2470亿美元,模型推理市场价值2970亿美元,总价值超过5000亿美元。Turing就是处在这一趋势上,即通过代码生成优化大模型的推理能力,资本自然对其抱有期望。

另外,Turing自身的“资源-效率-社区”特性,也筑牢了发展的护城河,提升了资本的信心。

资源领域,Turing拥有覆盖140个国家、超400万程序员贡献的代码,涵盖金融、生物、制造等垂直领域,能够形成差异化语料库。效率领域,在庞大资源的基础上,Turing凭借算法能够提升客户跟工程师的匹配效率,降低撮合成本。社区领域,工程师通过贡献代码获得高薪和成长,形成“贡献越多→技能越强→收入越高→吸引更多工程师”的正循环,从而推动Turing平台的壮大。

随着大模型的加速发展,资本认为Turing凭借这三板斧能够开拓更广阔的成长空间。更何况,AI基建赛道是个极为烧钱的领域,但Turing罕见地实现盈利,这也是吸引资本的重要一点。

三、DeepSeek时代:数据标记会消失吗?

虽然Turing发展得如火如荼,但很多人质疑其未来的发展空间。

他们认为越来越多的AI大模型能自动标记数据和生成代码,比如DeepSeek就能对数据进行自动标记和整理,还能通过自然语言描述生成代码。这意味着,Scale AI旗下的数据标记师、Turing旗下众多的程序员会面临淘汰风险。

事实上,完全抛开人类实现大模型的迭代是不现实的。

因为模型越复杂,越需要人类进行精准且高效的“数据指导”。比如,自动驾驶模型需要标注极端场景数据,医疗模型需专家验证病理特征,这些都无法完全依靠自动化的机器。另外,AI生成的代码仍需人类审核与优化。最优秀的AI代码生成器,一定由人类编写的代码训练而成。

Siddharth就描绘了一幅人类和AI共同推动大模型发展的图景,比如如果要求大模型分析顶级风险投资公司,它首先会利用金融专业人士的知识了解要寻找哪种数据,然后利用人类的编码知识编写一个脚本,访问相关数据并将其转换为正确的格式,接着做出深度的分析。

Siddharth表示,OpenAI的最新模型是给程序员的礼物,而不是生存威胁。

事实上,AI不是取代人类,而是放大人类的智慧。人类跟AI是可以共同协作的——人类进行数据标注和提供专业知识,AI将其转化为数据和逻辑,二者共同喂养更强大的模型。

数据就是数字化时代的原料,是21世纪的石油。当资本疯狂涌入大模型时,Turing的崛起揭示了一个趋势:

AI的“灵魂”不止于数据和算法,还在于数据背后的人类痕迹。工程师的每一行代码、医生的每一次诊断,都能成为喂养AI的养料。人类和AI之间是共生关系,而不是零和博弈。

参考资料:

1、Jonathan Siddharth的领英

2、Inside the company that gathers ‘human data’ for every major AI firm(Semafor)3、Turing, a key coding provider for OpenAI and other LLM producers, raises $111M at a $2.2B valuation(TechCrunch)

本文来自微信公众号:硅兔君,作者:Eric,编辑:伊凡